GEMINI featured in Ingeniøren (Danish)

24 June 2021

Ingeniøren / By Laurids Hovgaard

Hænderne på ryggen: Øjne, hoved og krop skal styre computeren

Trods årtiers forskning og udvikling er øjnene endnu ikke klar til at overtage styringen af en computer. Nu foreslår professor at kombinere bevægelser fra øjne, hoved og hele kroppen.

Fotorealistisk grafik i realtid med hurtig regnekraft, kameraopløsninger tæt på trecifrede megapixels og machine learning-algoritmer, der afkoder ufattelige mængder data på kort tid.

Det er altsammen teknologiske fremskridt, der er medvirkende til at accelerere brugen af extended reality-teknologier som virtual reality, augmented reality og mixed reality – forskellige versioner af hvordan den fysiske og digitale virkelighed kan smelte sammen.

Men på et punkt er alt ved det gamle. Måden vi styrer en computer på. Da Danmarks første computer, DASK, blev tændt tilbage i 1955 blev den styret med hænderne, og i dag foregår al styring stadig via et tastatur, en mus eller ved at swipe frem og tilbage på skærmen – med fingrene.

Selvom vores ti fingre har vist sig at være effektive, præcise og hurtige, så har de også en række begrænsninger. Skuldre og albuer gør, at skærmen helst skal placeres lige foran vores hænder, ligesom vi i dag gerne vil løse andre opgaver, samtidig med at vi kommanderer rundt med computeren.

»Der er mange situationer, hvor det er en fordel ikke at bruge hænderne, for tiden f.eks. for at undgå virus og bakterier, men også hvis vi har beskidte hænder, handsker på eller er i gang med andre opgaver, siger Hans Gellersen, professor i human-computer interaction (HCI) ved Datalogi ved Aarhus Universitet og Lancaster University.

Han har i mange år forsket i metoder til eyetracking, hvor øjnene anvendes til at kontrollere en computer.

»Øjnene er en oplagt kropsdel, fordi vi i forvejen bruger øjenbevægelser, når vi vil interagere med andre, og øjnene kan bruges som et pegeredskab ligesom en mus. For mennesker med handicap er eyetracking et vigtigt redskab og har været det længe, men når vi taler om mere generel brug af øjne til computerstyring, så er succesen mere begrænset,« siger Hans Gellersen.

I stedet for at skyde skylden på de store computerproducenter, vender han blikket indad på sit eget forskningsfelt, som han mener er gået for snæversynet til emnet, så at sige ved isoleret at se på øjenbevægelser.

»Man har ignoreret de samtidige bevægelser i hoved og krop. Vi styrer vores blik og visuelle opmærksomhed i naturlig og nødvendig koordination mellem øjne, hoved og krop,« siger Hans Gellersen.

Mange eyetracking-løsninger er i dag udviklet til almindelige computerskærme på under 50 tommer. Det betyder, at øjet kan se hele skærmen, uden at vi skal bevæge hovedet. Men sådan fungerer det ikke, når vi rejser os fra skærmen og bevæger os mere frit rundt i den fysiske virkelighed, hvor synsfeltet pludselig udvides radikalt.

»Derfor bruger vi også hovedet og hele kroppen til at fokusere vores syn. Når vi pludselig bliver afbrudt og hurtigt skal flytte fokus, så starter vi med øjnene, men sker det i en planlagt og bevidst handling, vil vi oftest starte med at flytte overkrop og hoved,« siger Hans Gellersen.

Styring med hele kroppen

I et nyt stort forskningsprojekt, Gemini, er det hans ambition at udvikle et system, hvor man bruger hele kroppen til at styre en computer. Visionen for projektet er, at brugerne bliver i stand til at interagere flydende i tre dimensioner med den fysisk-digitale verden omkring dem, både tæt på og på afstand ved en kombination af øjen-, hoved-, hånd- og kropsbevægelser som input til computeren.

»Det har et enormt potentiale for indvirkning på interaktive systemer, hvor berøring ikke er mulig, praktisk, ønskelig eller sikker. Hvis det lykkes, kan ‘blik i samspil med kroppen’ muligvis definere det næste store HCI-paradigme,« siger Hans Gellersen.

Og det er ikke kun til styring af computere, at kropssprog og bevægelser er i fokus. På SDU arbejder robotforskere med at give robotterne et intentionelt kropssprog, altså gøre dem bedre til at udstråle forskellige typer følelser. For når en robot nærmer sig et menneske, bliver intention og tone i mindst lige så høj grad afkodet ud fra kropssprog og stirren. Selvom stemmen er blid, stille og høflig, kan den opfattes som uvenlig og aggressiv, hvis den ledsages af en stirren.

Et klassisk problem inden for eyetracking går under navnet Kong Midas’ berøring og henviser til myten om den græske konge, hvis hænder forvandlede alt til guld.

Selvom det lyder som en indbringende evne, så var det også ret besværligt for Kong Midas at udføre helt almindelige hverdagsopgaver. Sådan er det også med eyetracking, fordi vi bruger øjnene til mange andre opgaver.

»Ved også at måle og følge krops- og hovedbevægelser forventer vi at kunne reducere problemet med, at computeren fejlagtigt aktiveres, eksempelvis ved at lade en hovedbevægelse bekræfte et valg med øjnene,« siger Hans Gellersen.

Kompleksiteten i, hvordan vi koordinerer forskellige dele af kroppen, forsøger de også at udnytte hos den danske høreapparatproducent Oticon, som tester, om man kan bruge øjnenes bevægelser til at optimere brugen af et høreapparat.

Hvis man ved, hvor en høreapparatbruger kigger hen, kan man nemlig justere høreapparatet, så lyden bedre modtages herfra, mens den omkringliggende støj filtreres væk.

Konkret bruger Oticon EEG-signaler, altså de elektriske signaler fra hjernen, som en indikator for, hvor brugeren kigger hen, men de er stødt på samme udfordring som Hans Gellersen: Det er ikke nok kun at fokusere på øjets bevægelser. For når vi flytter blikket fra en person til en anden, sker det ikke kun med øjnene, vi bruger også hovedet og hele kroppen til at fokusere. Derfor arbejder Oticon-forskerne også med gyroskoper og accelerometre, der måler hovedets bevægelser.

60 billeder i sekundet

I første omgang skal kroppens bevægelser i samspil med øjnene undersøges i et laboratorium, før Hans Gellersen kan flytte sin forskning ud i virkeligheden, som er markant mere kompleks.

»Tracking af kroppens bevægelser, inklusiv øjne, er på vej til at blive et software- og ikke et hardwareproblem. Vi har efterhånden gode og billige kameraer til at observere øjne, og vi bevæger os fra traditionelle computervision-algoritmer til machine learning-modeller, hvor vi kan nøjes med et billede af øjet og estimere, hvor det ser hen,« siger Hans Gellersen.

Artiklen fortsætter under grafikken.

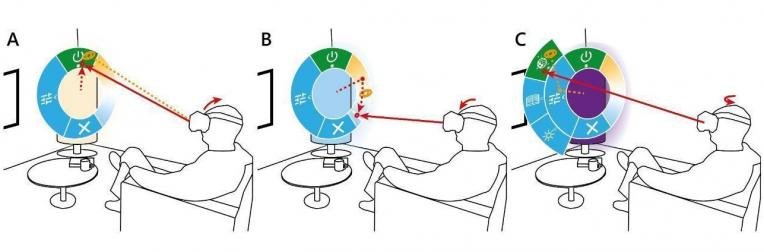

Sådan forestiller Hans Gellersen sig en radial menu, hvor øjnenes naturlige bevægelser anvendes som mus, der bevæger sig fra A til B og videre ud i en undermenu i C. Når man vil vælge et menupunkt, nikkes der med hovedet som et klik med musen. Illustration: Hans Gellersen

Han peger på, at der allerede findes kommercielle briller designet til augmented reality med indbygget eyetracking. Ingeniøren har tidligere testet finske Varjos high-end-briller til mixed reality, hvor du blander den fysiske verden med digitale lag oven på. Her kan Varjo lægge digitale billeder oven på den fysiske virkelighed, du ser gennem brillerne, med en hastighed på 90 frames i sekundet og en latenstid på 12 millisekunder. En tommelfingerregel er, at man helst skal over 60 billeder i sekundet og under 20 millisekunders latenstid for at slippe for ‘søsyge’ ved brug af VR-briller.

Men selv hvis hans grundforskning får kortlagt, hvordan kroppen fungerer i samspil med vores øjne, så er det ikke nødvendigvis nok til at levere en styring uden hænder.

»Vi er ovre i en klassisk hønen eller ægget-problemstilling. For tiden forsøger vi med øjnene at kontrollere computer-interfaces, som egentlig er designet til hænder. Det virker ikke ret godt. Men det er omkostningstungt at designe interfaces fra bunden med udgangspunkt i øjne, og ingen har rigtigt udpeget den helt oplagte killer-applikation,« siger Hans Gellersen.

Ud over at kortlægge kroppens bevægelser i samspil med øjnene arbejder han også med at udvikle og teste, hvordan man bedst styrer med øjnene.

»Radiale menuer er rigtigt interessante, fordi vi kan bevæge hovedet og øjnene i alle retninger, hvilket er noget anderledes end vores hænder, som sidder fast på skuldre og albuer,« siger Hans Gellersen.

Til trods for, at eyetracking ofte henvises til kategorien ‘teknologier, der aldrig rigtig er slået igennem’, hvor også virtual reality tit havner, så er Hans Gellersen stadig optimist.

»For ti år siden sagde jeg, at alle skærme ville have en eyetracking-løsning indbygget om ti år. Det er så ikke sket, men jeg siger det gerne igen: Om ti år vil alle skærme kunne registrere vores bevægelser,« lyder det fra en smilende Hans Gellersen.

This article was originally published in Ingeniøren.